HuggingFace gguf 파일을 Ollama 로딩

GGUF (GPT-Generated Unified Format)

HuggingFace Hub 설치

pip install huggingface-hub

순서대로

HuggingFace Repo- .gguf 파일명

- local-dir 설정

- 심볼릭 링크 설정

아래의 예시는 EEVE

- HF: https://huggingface.co/yanolja/EEVE-Korean-Instruct-10.8B-v1.0

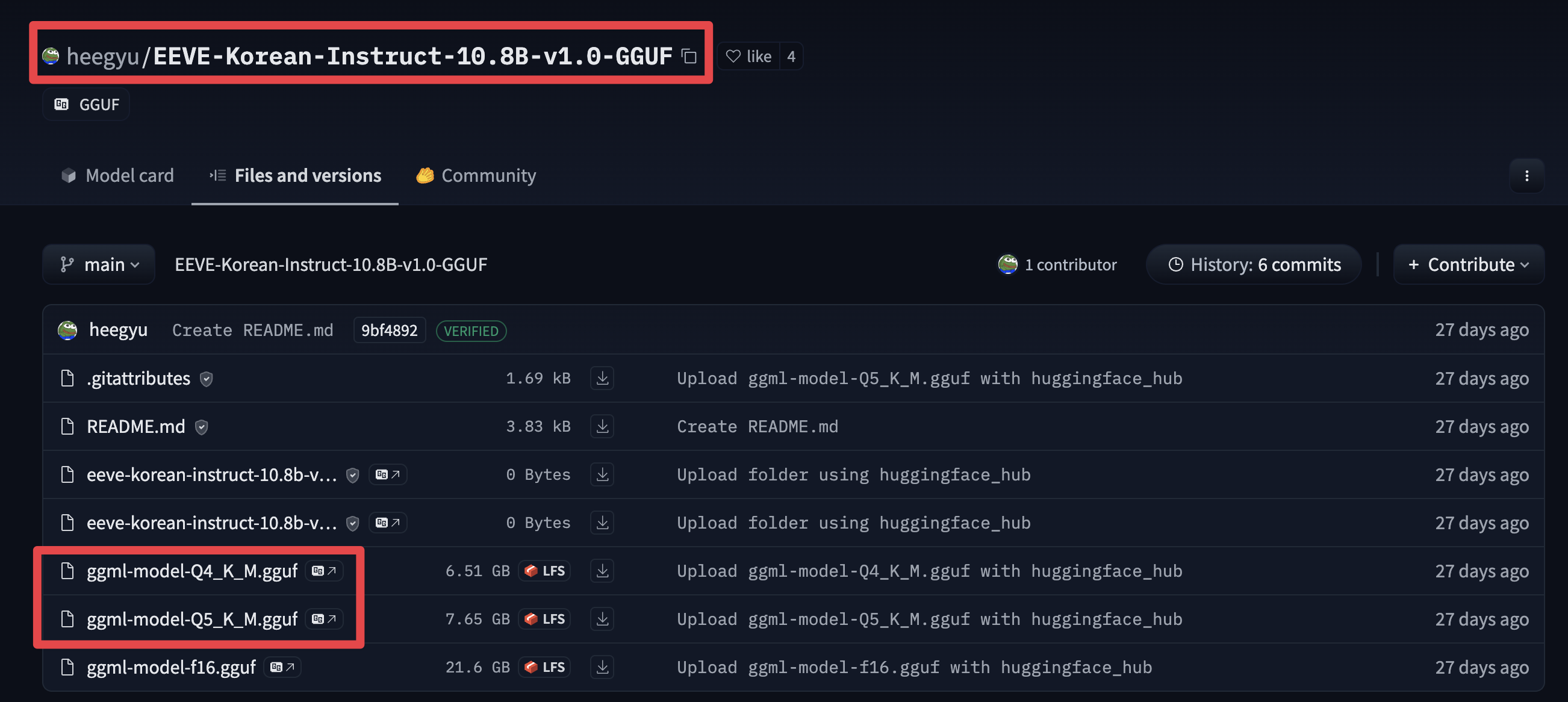

- GGUF: https://huggingface.co/heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF

huggingface-cli download \

heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF \

ggml-model-Q5_K_M.gguf \

--local-dir /Users/teddy/Dev/ollama/gguf \

--local-dir-use-symlinks False

다운로드하려는 gguf 파일의 이름을 지정해야 하며, 그렇지 않으면 모두 다운로드됩니다! 파일 및 버전 페이지에서 선택할 수 있는 모델 파일 목록을 찾을 수 있습니다.

Modelfile 로부터 커스텀 모델 생성하기

- 모델을 임포트하기 위해 ModelFile을 먼저 생성해야 합니다. 자세한 정보는 ModelFile 관련 공식 문서에서 확인할 수 있습니다.

Modelfile

FROM ggml-model-Q5_K_M.gguf

TEMPLATE """{{- if .System }}

<s>{{ .System }}</s>

{{- end }}

<s>Human:

{{ .Prompt }}</s>

<s>Assistant:

"""

SYSTEM """A chat between a curious user and an artificial intelligence assistant. The assistant gives helpful, detailed, and polite answers to the user's questions."""

PARAMETER stop <s>

PARAMETER stop </s>

또 다른 예시

Modelfile

FROM openbuddy-llama2-13b-v11.1.Q4_K_M.gguf

TEMPLATE """{{- if .System }}

<|im_start|>system {{ .System }}<|im_end|>

{{- end }}

<|im_start|>user

{{ .Prompt }}<|im_end|>

<|im_start|>assistant

"""

SYSTEM """"""

PARAMETER stop <|im_start|>

PARAMETER stop <|im_end|>

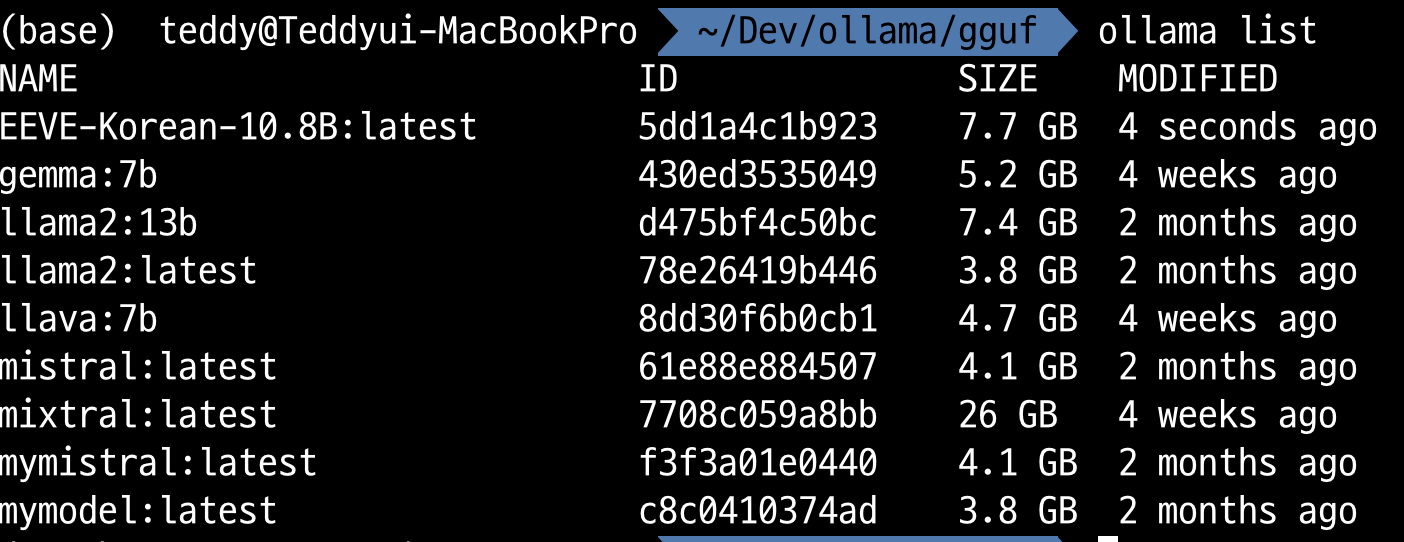

실행

ollama create EEVE-Korean-10.8B -f EEVE-Korean-Instruct-10.8B-v1.0-GGUF/Modelfile

ollama list

ollama run EEVE-Korean-10.8B:latest